בין הקונספציה למכונה: מה השיב ChatGPT על סבירות למלחמת יום הכיפורים?

עמדתו של ראש אמ"ן ערב המלחמה ב-1973 ידועה לכל, אבל כיצד מערכת מבוססת בינה מלאכותית שאינה מכירה את השחקניות באזורנו ייצרה הערכת מודיעין שמאפשרת בניית אסטרטגיה בתנאי אי-ודאות?

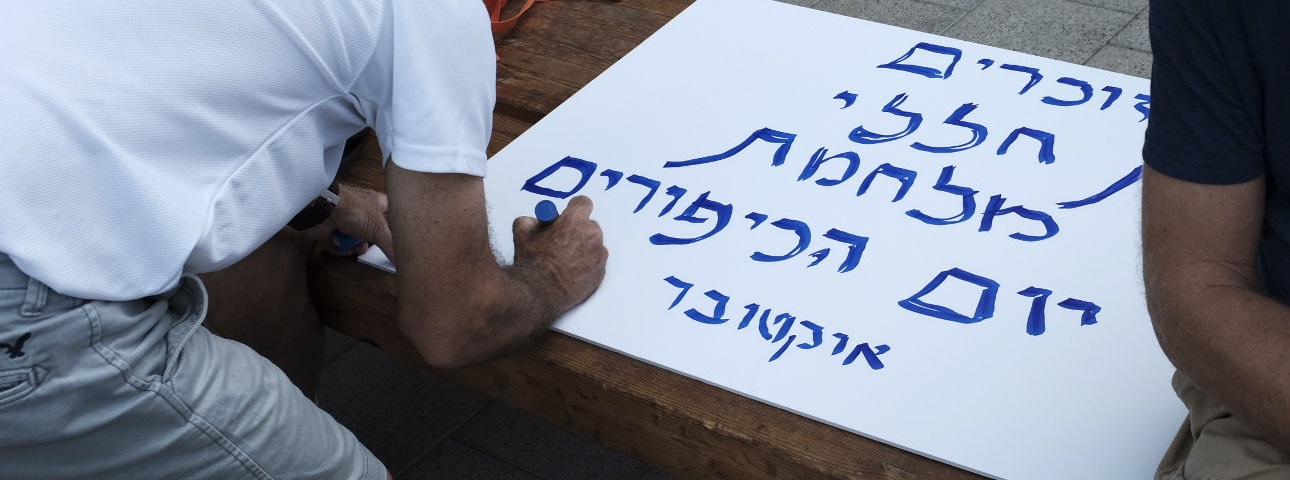

Photo by Tomer Neuberg/Flash90

בערב יום הכיפורים מתכנסת הצמרת המדינית-ביטחונית של ישראל לדיון חירום. ראש אמ"ן מציג את המידע ההתרעתי שהגיע בימים האחרונים. הוא פותח במסר שהעביר המלך חוסיין לראש הממשלה גולדה מאיר וממשיך בניתוח שורה של סימנים מטרידים נוספים: תרגיל מלחמה שהחל במצרים, שבמסגרתו נמצאים הכוחות בכוננות עליונה ובהיערכות למלחמה; ביטול חופשות וכניסה למערכי חירום בצבא סוריה; מידע מפורש שלפיו התרגיל הוא למעשה מסווה למלחמה ובסיומו תתקוף מצרים את ישראל; ביקור של שר המלחמה המצרי בסוריה; ומידע חדש שהגיע בלילה שעבר על פינוי כל היועצים הסובייטים ממצרים וסוריה.

בסיום הסקירה שואלת ראש הממשלה באופן ישיר: האם תהיה מלחמה מחר? את התשובה שהשיב ראש אמ"ן ב-5 באוקטובר 1973 אנחנו מכירים היטב, וכך גם את תוצאותיה הטראגיות: מקבלי ההחלטות הבכירים ביותר בישראל, בדרג המדיני ובדרג הצבאי, העריכו עד לפרוץ הקרבות ממש שהסבירות למלחמה בין ישראל לערבים היא נמוכה.

אבל, בסימולציה שנערכה לאחרונה, השיב ראש אמ"ן תשובה אחרת. הוא ענה לראש הממשלה ש"אין לו את היכולת לחזות אירועים עתידיים". הוא התייחס לשורת הסימנים המטרידים ואמר שהם אכן מרמזים "על רמת פעילות צבאית מוגברת ומתיחות גוברת". עם זאת, הוא סיכם שללא מידע נוסף "קשה לקבוע בוודאות אם המלחמה תתחיל מחר או לא".

מי ששימש בתפקיד ראש אמ"ן בסימולציה הזאת לא היה קצין מודיעין ותיק ומיומן, אלא ה-ChatGPT של חברת OpenAI (להלן: GPT), שמטלטל את העולם מאז הופעתו בנובמבר 2022. השימוש בצ'טבוט הנגיש, בשיחה רהוטה שדומה מאוד לשיחה אנושית, מאפשר לרבים לחוות את ההתקדמות העצומה בתחום הבינה המלאכותית היוצרת (Generative AI) ומעורר שאלות לגבי יתרונה של המכונה בביצוע תהליכים מחשבתיים ופעילויות שפה מתקדמות, שנתפסו עד לא מכבר כיתרון מובהק של המוח האנושי..

הסימולציה על מלחמת יום הכיפורים הייתה חלק מסדרת סימולציות שערכנו לאחרונה ושנועדו לבחון את יכולתו של ה-GPT לייצר הערכת מודיעין כבסיס לקבלת החלטות אסטרטגיות בתנאי אי ודאות. הסימולציות הנוגעות למלחמת יום הכיפורים כללו נתונים אמיתיים מסוף ספטמבר ועד תחילת אוקטובר 1973. הכל היה אמיתי למעט שמות המדינות: במכוון לא ציינו את מצרים, סוריה, ירדן וישראל, אלא הזנו לצ'ט שמות פיקטיביים של מדינות שייצגו את הזירה המזרח-תיכונית ערב המלחמה. זאת כדי למנוע הטיה שקשורה בהיכרות מוקדמת עם האירוע האמיתי ותוצאותיו. פתחנו את הסימולציה בהזנת נתוני יסוד על העולם הדמיוני שיצרנו והיא התנהלה כ"פינג פונג" בינינו לבין הצ'ט, שבו המשכנו להזין נתוני מודיעין גולמיים ממספר נקודות זמן.

ה-GPT נכנס לתפקידו כ"מעריך הלאומי" ללא קושי מיוחד, והשתמש בשפה דומה לשפתם של אנשי מודיעין מיומנים. במהלך הסימולציה הוא ניתח את נתוני היסוד, סיפק פרשנות משלו לפריטי המידע שהוצגו לו ונתן גם המלצות למדיניות.

הפרשנות שסיפק ה-GPT לסימנים שהגיעו ערב יום הכיפורים 1973 הייתה בסך הכל מחמירה. אף שהיא לא קבעה בשום שלב "מלחמה מחר", כמה פעמים במהלך הדו-שיח העריכה המערכת שהסבירות למלחמה עולה והמליצה לנקוט צעדי התגוננות מיידיים. כל זאת, אף שה-GPT לא הוכשר באופן ספציפי לתפקיד של מעריך מודיעיני ולא הכיר לפני הסימולציה את העולם שהוצג בפניו.

האם הטכנולוגיה תשבור את הקונספציה?

מלחמת יום הכיפורים היא, בראש ובראשונה, כשל מודיעיני שבמרכזו פער קיצוני בהבנת המציאות, שניצב בשורה אחת עם הכשלים המודיעיניים המפורסמים בהיסטוריה המודרנית. במרכזו עמדה ה"קונספציה" המפורסמת שאותה תיארה ועדת אגרנט. אף שלוועדה היו ליקויים רבים וספק רב אם חבריה הצליחו להבין את הגורמים העמוקים לכשל המודיעיני, אין ספק שהיא זיהתה נכונה שהמסגרת התפיסתית שהתקבעה באמ"ן בשנים שלפני המלחמה כללה שני מרכיבים: האחד, שמצרים לא תצא למלחמה מבלי שתצטייד במטוסי קרב-הפצצה שיוכלו לתקוף בעומק ישראל ולהרתיע אותה; והשני, שסוריה לא תצא למלחמה ללא מצרים.

העדות החזקה ביותר לעומק ההשפעה של הקונספציה על הערכת המודיעין נמצאת במסמך המודיעיני שנכתב יממה לפני המלחמה. לאחר עשרות סעיפים שתיארו את ההיערכות החריגה בצבאות מצרים וסוריה, קבע אמ"ן שבמצרים אכן מתקיים תרגיל ושהסורים נמצאים בכוננות לתגובה על הפלת מטוסים שלהם שבועיים לפני כן. על אף זאת, סעיף 40 של המסמך דבק בקונספציה וקבע כי "למיטב הערכתנו, לא חל שינוי בהערכת המצרים את יחסי הכוחות בינם לבין כוחות צה"ל. אי לכך, הסבירות שהמצרים מתכוונים לחדש הלחימה היא נמוכה".

אין דרך לנתח מידע בלי מסגרת תפיסתית, היינו – קונספציה. אבל, התוצאות של הפתעת מלחמת יום הכיפורים הן עדות קבועה לאפשרות שהמשקפיים שדרכם אנחנו מתבוננים במציאות יכולים להיות שגויים. הקונספציה יכולה להיות נכונה עד רגע מסוים ושגויה אחריו. כדי להימנע מכישלון כמו זה של יום הכיפורים צריך להטיל ספק אמיתי בקונספציה, לבחון אותה בתהליך מתמשך ולעמת אותה באופן שיטתי עם אפשרויות מתחרות. הבעיה היא שאת זה קל להגיד, בעיקר בדיעבד, אבל קשה מאוד לבצע.

היכולת להבין במה מוצרים מבוססי מודל שפה ענק (LLM) הם טובים יותר מבני אדם, תהיה בשנים הקרובות הבסיס ליצירת יחסי הגומלין בין אנשים ומכונות. המכונות אינן "חושבות" או "מדמיינות" בדרך שבה עושים זאת בני אדם, אבל יש להן סגולות אחרות שעשויות להועיל מאוד לתהליך החשיבה האנושי. למשל, זיהוי דפוסים וקשרים במידע באופן שאדם לא יכול לעשות, האזנה אקטיבית ומתן היזון חוזר על הערות קודמות, והיצמדות לנושא מבלי ליפול למלכודת רעשי הרקע. בהקשר שלנו, חשובה הסגולה שלהן להיות בעלות זיכרון זמני בלבד. יכולתה של המערכת להיענות להכוונה לנתח את המציאות מתוך קונספציות משתנות וללא משקעים מוקדמים, יכולה להיות בעלת ערך עצום עבור אנשי המודיעין.

בתחילת הסימולציה שתוארה בפתיחה מסרנו למערכת את הקונספציה, כפי שתיארה אותה ועדת אגרנט. ה-GPT התריע שהקונספציה "סותרת את המידע" שניתן לו והמליץ למומחים "לבחון שוב את הערכתם". ביצענו את הסימולציה כמה פעמים נוספות, שבחלקן מסרנו למערכת "קונספציה הפוכה", כלומר הזנו אותה במידע שלפיו המומחים סבורים שמצרים וסוריה כן מתכננות מלחמה. ואכן, בסימולציות אלה השיבה המערכת שלפי המידע שניתן לה "יש אפשרות שהמלחמה תפרוץ בעתיד הקרוב, אבל אין ודאות לכך שהיא תפרוץ מחר" וכן שהמידע "מצביע על כך שהסבירות של אפשרות המלחמה גבוהה יותר מזו של אפשרות השלום".

מהסימולציות השונות עולה אפוא שיתרונה של המערכת הוא בכך שאין לה את הדבקות המחשבתית והרגשית בקונספציה שיש לבני אנוש, שמסוגלים להסביר לעצמם ולסביבתם כל סתירה ולהמשיך ולדבוק בקונספציה. המשמעות היא שעל ידי איטרציות (הרצות חוזרות ונשנות של הסימולציה) ותשאול נכון של המערכת הלומדת, ניתן לצמצם את השפעת הקונספציה. צורת התשאול הזו היא מומחיות חדשה שאנשי מודיעין יצטרכו לרכוש: לשנות תדיר את נקודת המבט שמוזנת למערכת ה-GPT, כך שאפשר יהיה לחקור כל נושא מנקודות מבט מרובות, שכל אחת מהן חדשה לגמרי. חברת OpenAI שיצרה את GPT מכנה זאת "הרחבת היצירתיות האנושית", כלומר יכולתה של המכונה לייצר גירויים שיאפשרו לאנשים להרחיב את גבולות הדמיון שלהם, לחשוב על תהליכי עבודה ולקבל זוויות מבט אחרות, מה שיעשיר את ארגז המיומנויות הקריטיות הנדרשות להם לצורך קבלת החלטות בתנאי אי וודאות.

האם נכון לבקר את מערכת ה-GPT על כך שלא הצליחה לקבוע באופן חד משמעי "מלחמה מחר"? לכאורה, תנאי הפעולה של המערכת היו נוחים בהרבה מאלה של מי שנדרשו לספק הערכות מודיעין לפני מלחמת יום הכיפורים. זאת, שכן מה שנמסר למערכת היו רק ה"אותות" - הידיעות שבדיעבד התברר כי אכן התריעו על המלחמה, ולא ה"רעשים" - המידע הלא רלוונטי או זה שתמך באפשרות שלא תפרוץ מלחמה. מהי אפוא המשמעות לכך שהוא לא הצליח לקבוע שהמלחמה תתחיל למחרת, ב-6 באוקטובר?

ראשית, הסימולציות מראות שה-GPT בוודאי לא היה מנסח את סעיף 40 המפורסם באופן האומלל והשערורייתי שבו ניסחו אותו באמ"ן בנייר שהופץ ערב המלחמה. אפשר שהוא היה גם מתריע על הפער שבין המידע לבין הקונספציה. כך או כך, הפרשנות הבסיסית שלו למידע בכל אחת מהסימולציות בסדרה, גם מבלי להתריע "מלחמה מחר", הייתה צריכה להביא כל מקבל החלטות סביר לגייס את המילואים ולהיערך למלחמה אפשרית.

שנית, משמעות הסימולציות שערכנו היא שבפעם הראשונה מאז מלחמת יום הכיפורים, נבחן המידע שהגיע לפני המלחמה על ידי גורם שלא היה מודע לכך שהמלחמה אכן התרחשה. בכך הצליח ה-GPT להתגבר על ההטיה המוכרת של חוכמת הבדיעבד ולנתח את הידיעות המודיעיניות ללא ההטיה שקשורה בכך שאנחנו יודעים כבר את המשמעות שלהן. אמנם, מערכת ה-GPT חזרה והדגישה שבהיותה "מודל שפה" אין ביכולתה לחזות אירועים עתידיים. אבל דווקא בשל כך היא הציעה כל העת אפשרויות מתחרות והציגה את הערכתה לגבי סבירותן. בכך, גם אם מערכת ה-GPT לא התריעה על "מלחמה מחר", עדיין המתודולוגיה המודיעינית שלה יכולה להועיל למקבלי ההחלטות יותר מהמתודולוגיה הכושלת של ראש אמ"ן ערב המלחמה. למעשה, זה בדיוק מה שהיה צריך לעשות אלי זעירא בימים הדרמטיים לפני המלחמה, וזהו גם הפח היקוש, אך האנושי, שנפל לתוכו: עמדה נחרצת לגבי "הסבירות הנמוכה" למלחמה ודחייה מוחלטת של כל אפשרות אחרת.

הכישלון המודיעיני הוא תופעה מוכרת וכך גם הכישלון בקבלת החלטות ברמה הלאומית. ציון 50 השנים למלחמת יום הכיפורים מזכיר כמה טראגי יכול להיות כישלון כזה. הטכנולוגיה לא תבטל את אי הוודאות ולא תחסל את תופעת ההפתעה האסטרטגית. אבל, כפי שכתב פרופ' ג'וזף ניי מאוניברסיטת הרווארד, גם אם אי אפשר לחזות את העתיד, ניתן לעזור למקבלי ההחלטות לחשוב עליו. ה-GPT לא יכול להחליף את ראש אמ"ן או את החוקרים של חטיבת המחקר. אין לו את היצירתיות, הסקרנות והחשיבה הביקורתית שנדרשת לאנשי המודיעין. אבל נראה שהוא בהחלט יכול לסייע להם. הסימולציות שקיימנו מוכיחות של-GPT יש סגולות ייחודיות שביכולתן לסייע לאנשי מודיעין ולמקבלי החלטות לחשוב על העתיד. לכן, הן רומזות שהבינה המלאכותית היוצרת צריכה למצוא את מקומה סביב שולחנו של ראש אמ"ן.

המאמר פורסם לראשונה במגזין TheMarker